Carros autónomos: o dilema da reação vs decisão

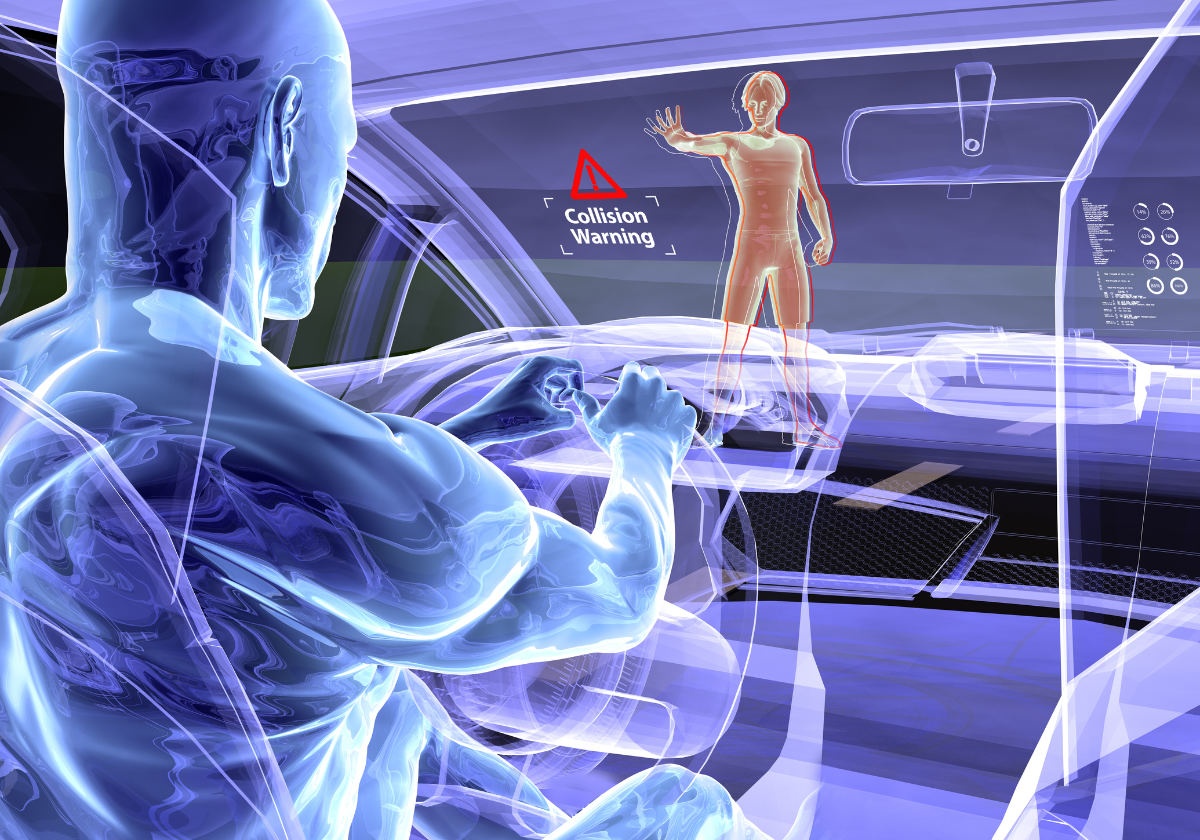

Com os avanços tecnológicos dos últimos anos, os carros autónomos deixaram de ser uma visão futurista para se tornarem uma realidade cada vez mais próxima das estradas portuguesas e europeias. No entanto, à medida que se desenvolvem sistemas de condução automatizada, surgem questões éticas profundas: quem decide o que fazer em caso de acidente iminente? Deve a máquina proteger sempre o condutor, os ocupantes, ou os peões?

Estes dilemas morais, muitas vezes inspirados no clássico "trolley problem", levantam debates importantes sobre a responsabilidade, a segurança e a programação de valores numa máquina que, teoricamente, toma decisões de vida ou morte em milésimos de segundo.

Artigo relacionado: Carros autónomos: como será o futuro da mobilidade?

O Dilema moral da condução autónoma

Imagine que um carro autónomo circula a alta velocidade numa estrada. Subitamente, surge um obstáculo: um peão atravessa fora da passadeira. Não há tempo para parar. O sistema tem de escolher: desviar-se e atingir outro veículo ou prosseguir e atropelar o peão.

Este é apenas um dos inúmeros cenários que têm sido analisados por investigadores e legisladores em todo o mundo. A MIT Moral Machine recolheu mais de 40 milhões de respostas a dilemas semelhantes, revelando que diferentes culturas e países têm percepções muito distintas sobre o que deve ser priorizado: jovens ou idosos, peões ou ocupantes, humanos ou animais.

Mas a questão vai além da ética individual. No mundo real, a decisão não depende de emoções ou reflexos, depende de algoritmos, sensores e prioridades de programação. E aqui começa o verdadeiro desafio: como programar moralidade?

A consciência da máquina: decisões programadas

Ao contrário de um ser humano que pode agir instintivamente, um veículo autónomo depende de dados estruturados e lógica codificada. Esses dados são processados por sistemas de inteligência artificial que analisam o ambiente em tempo real, desde o comportamento dos peões até à distância dos obstáculos e velocidade dos outros veículos.

Segundo a norma ISO 26262, aplicada à segurança funcional de sistemas automotivos, os fabricantes devem garantir que as decisões do sistema priorizam a segurança em todos os cenários previsíveis. No entanto, o problema surge quando duas opções seguras são impossíveis, por exemplo, quando todas as decisões implicam um dano.

Os programadores enfrentam então a difícil escolha: devem proteger sempre os ocupantes? E se isso implicar atropelar peões? Ou deve a máquina sacrificar o condutor para evitar múltiplas mortes?

A União Europeia, através da UNECE (Comissão Económica das Nações Unidas para a Europa), tem vindo a definir princípios para a ética da condução automatizada. Um dos consensos emergentes é o de que os veículos não devem discriminar com base em idade, género ou estatuto social. No entanto, estas orientações ainda carecem de tradução legal vinculativa.

Exemplo real: Tesla, Waymo e Mobileye

Nos últimos anos, vários sistemas de condução autónoma foram colocados em teste em contextos reais:

- Tesla Full Self-Driving (FSD) ainda não é considerado nível 4 de autonomia (sem intervenção humana), mas já enfrentou decisões críticas documentadas em situações de tráfego intenso.

- Waymo, subsidiária da Alphabet (Google), opera frotas de robotáxis em cidades dos EUA. Em 2023, um dos seus veículos colidiu com um camião de reboque estacionado indevidamente, levantando questões sobre percepção e reacção.

- Mobileye, da Intel, trabalha com fabricantes europeus na implementação de sistemas de condução assistida com IA baseada em cloud, reduzindo o tempo de decisão através de aprendizagem colectiva.

Estes casos mostram que a tecnologia está próxima, mas não infalível. E à medida que os veículos autónomos se tornam mais populares, surgem novas questões: quem é responsável em caso de erro, o fabricante, o programador, o condutor ou a própria IA?

O papel da legislação europeia

Atualmente, a condução autónoma de nível 3 e 4 (em que o sistema pode conduzir sem intervenção humana em determinadas condições) é permitida em alguns países da UE, como a Alemanha, mas ainda não foi plenamente integrada no Código da Estrada português.

O Regulamento da UNECE nº 157 já define requisitos técnicos para a homologação de sistemas de condução automatizada (ALKS – Automated Lane Keeping Systems). Contudo, a responsabilidade civil e penal continua em debate.

Artigo relacionado: “Ideias parvas” da Volvo podem salvar um milhão de vidas

Em Portugal, não existe ainda legislação específica para carros autónomos de nível 4 ou 5. A DGV e o IMT têm acompanhado os testes-piloto a nível europeu, mas será necessário atualizar o Código da Estrada e o regime de responsabilidade civil para abranger a intervenção da IA em acidentes.

A ética programada e os limites da decisão

A grande questão continua a ser: quem define as prioridades da máquina? E como garantir que essas decisões são transparentes e auditáveis?

Investigadores têm proposto modelos híbridos, onde a IA toma decisões em frações de segundo, mas baseadas em valores definidos pelo utilizador no momento da compra (por exemplo, modo “proteger ocupantes” vs “mínimo dano geral”). Esta abordagem, contudo, levanta preocupações éticas sobre desigualdade e responsabilidade.

Há também desafios técnicos: como garantir que o sistema reconhece corretamente ciclistas, peões, animais ou objetos no meio da estrada? O Euro NCAP já inclui testes de sistemas de assistência à condução nos seus protocolos de segurança, mas a transição para a autonomia total continua distante.

Conclusão: entre a decisão e a confiança

Os carros autónomos prometem uma revolução na mobilidade, reduzindo erros humanos, melhorando a fluidez do trânsito e diminuindo drasticamente o número de acidentes. No entanto, essa revolução só será bem-sucedida se for acompanhada por reflexão ética, legislação clara e responsabilização transparente.

Até lá, a “consciência da máquina” continuará a ser uma construção humana, sujeita às falhas, enviesamentos e limitações de quem a programa.